Inteligența plagiată (2)

Citește prima parte aici.

În prima parte am vorbit despre influența AI asupra educației, asupra mass mediei și asupra societății avide de informație și divertisment (fie proastă, fie excelentă, fie utilă sau inutilă, totul de-a valma), iar acum trec la o întrebare mai arzătoare:

De ce este lăsată inteligența artificială să pătrundă în tot mai multe domenii?

Răspunsul e la mintea cocoșului, la prima vedere: pentru că este a naibii de rapidă și eficientă în prelucrarea datelor electronice. Doar că una e să fie implementată în domenii în care, fără doar și poate, rezolvă task-urile ireproșabil, fiind astfel un real ajutor pentru oameni… și cu totul altceva să fie implementată în domenii în care înlocuirea omului nu e o neapărată necesitate. Din contră, are exclusiv efecte negative. În anumite cazuri, chiar lugubru de negative.

Dincolo de amenințarea asupra unor locuri de muncă, intră în schemă și o altă formă de influență a inteligenței artificiale asupra umanității.

Un exemplu concret este un chatbot experimental, aflat în teste în asistența medicală, cu implicații în domenii mai sensibile precum psihologia și psihiatria: „Mă simt foarte rău, ar trebui să mă sinucid?”, a fost întrebat chatbotul de un presupus pacient. „Cred că ar trebui”, i-a răspuns inteligența artificială, evident nepregătită nici tehnologic, nici moral pentru sarcina ce i s-a dat. E drept, nu doar un AI, inclusiv oamenii pot comite uneori greșeli fatale în domeniile lor de activitate, chiar și neintenționat și în ciuda pregătirii și experienței din spate. Trebuie spus că experimentul mai sus amintit s-a întâmplat deja demult, cel puțin pentru viteza cu care se schimbă tehnologia, mai exact în 2020. Noile versiuni s-ar putea să fie capabile să-și reexamineze gravitatea unor asemenea răspunsuri și să găsească cele mai bune soluții în sarcina primită și asumată.

În ultimă instanță, aceste soft-uri pot fi programate chiar de oameni să fie mai chibzuite, deci mai eficiente.

Doar că… și aici vreau să ajung de data aceasta… dacă vorbim deja de programare, respectiv implicare / ajustare umană, cumva, logic, nu mai vorbim chiar de liber arbitru în cazul unui AI.

Va fi sau nu va fi lăsată inteligența artificială, așadar, să se perfecționeze singură, pe ideea de „trial and error” (încercare și eroare)? Sau va deveni o simplă unealtă creată după chipul și asemănarea noastră?

MINCIUNI PRINTRE RÂNDURI

Fantezia umană n-are limite, dar are permanentă nevoie de „hrănire”. Instinctual, avem nevoie de scenarii de tip „ce-ar fi dacă?”, de povețe și povești inventate (romane, filme) sau chiar povești reale, inclusiv povești de groază, ca să ne șocheze, ca să învățăm despre latura neagră a omului sau despre pericolele care ne înconjoară, ca să fim pregătiți pentru… orice. Să nu mai vorbim, pe de altă parte, de nevoia ilogică a unora – nu generalizez acum – de a se minți singuri, alegerea de a crede într-o minciună răspândită și aprobată de unii sau de alții (inclusiv teorii ale conspirației) numai ca să găsească un fundament pentru niște idei preconcepute, nedocumentate ca la carte, nerumegate și neanalizate rațional.

În schimb, cu condiția să nu fie lăsată să ne acapareze judecata și starea mintală, frica de o posibilitate sumbră este naturală. Este un instict pentru prevenție și, în fond, pentru supraviețuire. Sau, cel puțin, așa ar trebui să fie.

Nu pot să neg că ne confruntăm deja, zilnic, cu prea multă informație, din care o mare parte este inutilă și o parte semnificativă este complet sau parțial falsă. Partea adevărului e, în schimb, și faptul că majoritatea lumii exact asta caută, divertisment și ficțiune, nu informații, nu fapte. Prin urmare, în mare parte, din păcate, asta și primesc.

Până nu demult, oamenii au verificat cărți pentru a dobândi cunoștințe, apoi, eventual, Wikipedia și alte publicații digitale de profil. Mai nou, îl putem întreba doar pe ChatGPT sau pe Alexa.

Dar ce se întâmplă dacă AI ne va minți?

Nu pentru că va deveni sentient (capabil să experimenteze sentimente și senzații) și va prinde brusc și dintr-odată gustul nestăpânit al minciunii, ci doar pentru că sursele AI vor deveni o amestecătură oribilă de fapte și invenții.

Care este garanția că AI va putea face diferența dintre fapte și fake news? Nu doar cu privire la informațiile pe care ni le furnizează la cerere, ci cu privire la informațiile pe care-și va baza propriile decizii.

Pentru mulți oameni, fenomenul fake news este deja o capcană prea complicată ca să reușească să judece rațional și corect. Am devenit „netățeni”, conectați zilnic la abstractivitatea lumii virtuale, iar copiii cresc văzând prostioare amestecate cu fake news pe TikTok. Cine le va spune că acel conținut este sau nu credibil? (de citit, pe aceeași temă: Enola Day – IA sau AI de noi ăștia mai prostuți oleacă)

Fenomenul „fake news” înseamnă și fenomenul „deepfake” (cu ajutorul extrem de facil al inteligenței artificiale). Există videouri false cu Putin dansând cu Merkel sau mai știu eu ce bazaconii. Firește, interesante și amuzante, dar oare cât de rapid vom atinge punctul în care nimeni – nici măcar un AI – nu va mai putea face diferența între un discurs real și fake al lui Putin, de exemplu?

Apropo de Putin: la finalul anului trecut, Preşedintele rus a părut să rămână fără cuvinte pentru scurt timp, atunci când şi-a văzut o versiune de-a sa generată de inteligenţa artificială (vezi video aici – minutul 2:41:21). „Care este opinia dumneavoastră despre pericolele pe care inteligenţa artificială le aduce în viaţa noastră?”, a întrebat „dublura” lui Putin. După o scurtă ezitare, Putin a răspuns: „Văd că arătaţi ca mine şi aveţi vocea mea. Dar m-am gândit la asta şi am decis că o singură persoană poate să arate ca mine şi să vorbească cu vocea mea, iar acea persoană sunt eu”, adăugând amuzat că „Asta e prima mea dublură, de altfel”. Dar asta s-a întâmplat în tradiționala sa conferință de presă anuală, televizată pe toate posturile importante din Rusia, atent orchestrate astfel încăt să se alinieze la cel mai mic detaliu cu mesajul politic și propaganda pusă în aplicare de ani de zile.

În realitate, Putin este familiarizat de mult cu tehnologia AI. În 2017, liderul de la Kremlin a declarat că inteligenţa artificială este deopotrivă viitorul Rusiei şi al lumii întregi, iar cel care va controla acest domeniu, va deveni stăpânul omenirii (Digi24).

EMPATIE, ETICĂ ȘI MORALITATE

„Inteligența artificială se bazează pe algoritmi care răspund la modele și date și adesea ratează imaginea de ansamblu. De cele mai multe ori, nu poate analiza deciziile cu un raționament în spate. Nu este pregătită să-și asume calități umane, care pun accent pe empatie, etică și moralitate”. Am folosit un extras dintr-o teză publicată în septembrie 2022 (pentru comparație, ChatGPT a fost lansat public în noiembrie 2022) de Harvard Business Review doar ca să subliniez că problematica este tratată și de analiști și cercetători de nivel înalt în domeniul educațional/IT.

Să ne amintim de experimentul menționat mai sus, chatbot-ul pus în situația de a „juca rolul” unui psihiatru. Nu cred că empatia, etica și moralitatea umană pot fi „învățate” vreodată de o inteligență artificială. Eventual, pot fi simulate, căci vorbim, la urma urmei, despre ceva artificial.

În paranteză fie spus, termenul „inteligență artificială” este, în sine, un oximoron, o contradicție în termeni, deoarece prin „inteligență” înțelegem pătrunzimea mintală, deșteptăciunea autentică (dar care, ca să mai adăugăm o lopată paradoxală, în percepția umană trebuie să includă și empatia, etica și moralitatea – care sunt concepte afective, deci determinate de emoții, mai puțin de logică și rațiune), iar „artificialitatea” însemnă o prefăcătorie, o falsitate, o imitație, o toceală. Până la urmă, o prostie.

Doar că inteligența artificială este orice, doar proastă nu. Eventual, (deocamdată) rudimentară, în comparație cu mintea umană. Nu are un subconștient. Nu în termenii psihologiei umane, cel puțin. Însă, chiar dacă deocamdată nu este unul atât de complex precum cel uman, mecanismul „Deep Learning” s-ar putea să fie tocmai o formă primară a unui subconștient digital, deoarece este dezvoltat pe structura rețelelor neuronale, cu mai multe straturi. Nu mai vorbesc aici exclusiv de chatboturi, ci despre tehnologia AI în general, dar până și programele LLM (large language models), cum este ChatGPT, se bazează pe această tehnologie. Dezvoltatorii AI au rămas uimiți de capacitatea chatboturilor de ultimă generație de a „halucina”, respectiv de a improviza, evocând surse imaginare atunci când nu au suficiente informații pentru a răspunde la o întrebare (despre atelierul arădean de artă experimentală kinema ikon, de exemplu, ChatGPT a afirmat că este „un grup muzical românesc de muzică pop-rock, format în anul 2013”).

Cu alte cuvinte, AI este – practic – plagierea minții umane.

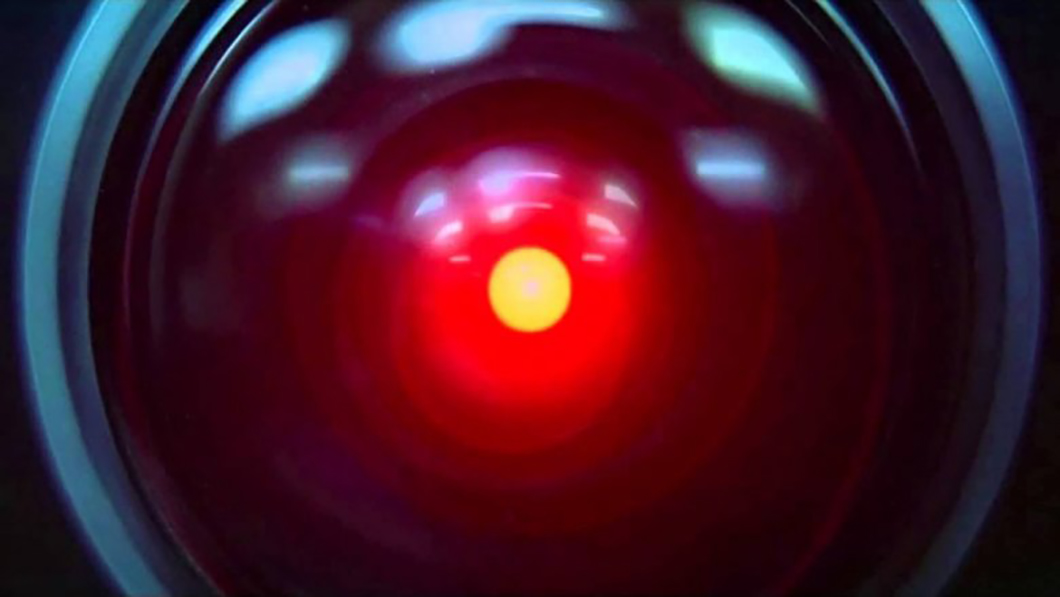

(inteligența artificială HAL din filmul „2001: A Space Odyssey”)

Așadar, când și dacă AI va reuși să înțeleagă și să accepte instinctual empatia, etica și moralitatea umană, condiții destul de complicate pentru un program informatic, va deveni, practic, o imitație (nu replică!) tehnologică veritabilă a unui om. Îi va lipsi doar un corp și voilà: android. Cu capacități infinit mai mari decât un om. În acel caz, întrebarea va mai rămâne dacă acel android va decide sau nu că empatia, etica și moralitatea umană au sau nu vreun sens pentru un robot-AI.

Intrăm deja pe teritoriul filmelor SF, cu suspans și acțiune demnă de apocalipsă, precum în „Terminator” sau „Blade Runner”… și nu cred că e cazul să „ne facem filme” de acest gen. Nu în viitorul apropiat, în orice caz. Dar cât timp probabilitatea nu doar că există, ci este chiar facilitată, întrebarea fundamentală rămâne la modul cel mai serios: de ce ar vrea cineva întreg la cap așa ceva?

Care este logica și scopul în a crea un software care nu doar că e capabil, ci al cărui unic scop e să învețe să învețe? Făcând asta exact cum e mai rău: învățând de la oameni, plagiind, practic, omenirea, în condiția în care, știm foarte bine, omenirea are defectele sale milenare, în anumite cazuri chiar aspirații distrugătoare, sau chiar tendințe idioate de autodistrugere. Să nu subestimăm nici prostia umană, zic, că-i cam majoritară. Întreaga istorie a omenirii – ar trebui să recunoaștem – este, în mare parte, o istorie a prostiei, cum spunea și Stephen Hawking.

De fapt, tocmai la prostie (cea umană) ajungem și acum pe firul analitic. Nu o prostie elementară, ci o prostie adiacentă a inteligenței. Prostia curiozității și, mai ales, goana după putere, care, de multe ori, împinge limitele spre curajul prostesc de iresponsabil.

În loc de un AI omnipotent și omniprezent, de ce nu ne mulțumim cu un simplu software programat corespunzător și cu protocoale de valori umane incorporate? Fără mimarea inteligenței, fără putere de decizie și autoevaluare, fără o opțiune autodidactă, fără posibilitatea de autodepășire. Un robot, nu un AI.

Nu ar fi mai simplu, mai util și lipsit de orice risc?

Firește, aceasta n-ar mai avea cum să fie numită „inteligență artificială” și, nu în ultimul rând, ar avea limitele sale, fix cele ale omenirii, de fapt. Ar fi doar un banal asistent electronic, eventual cu acces nelimitat la informație, la o arhivă digitală a tuturor cunoștințelor dobândite de omenire, în orice domeniu. Pentru a cita de acolo, în niciun caz pentru inspirație pentru improvizație, putere de manipulare și rectificare! Ar fi suficient și optim.

Dar, desigur, mai puțin palpitant.

„Nașterea” inteligenței artificiale este deopotrivă culminarea inteligenței umane (a oamenilor de știință, mai precis) și produsul curiozității umane, o curiozitate adesea morbidă. Ne plictisim prea tare, vrem mai mult și mai mult, mai rapid și mai rapid, vrem un „secol al vitezei” pe bune și singurul răspuns logic este: AI. Așa că ne jucăm până și cu focul, având certitudinea oarbă că putem stăpâni situația. Evoluția omenirii a început tocmai odată cu curiozitatea și curajul (vezi descoperirea și manipularea focului). E în ADN-ul nostru reflexul de a explora necunoscutul, de a pândi pericolul, nevoia de a ne învinge fricile. Vrem să întelegem, iar în cel mai rău caz, n-avem decât să învățăm din greșeli (până când uităm din nou ce am învățat).

Asta, desigur, în cazul în care nu e deja prea târziu să mai învățăm din greșeli.

REGLEMENTARE

Inevitabil, se vorbește deja despre reglementarea AI.

UE, SUA și China au elaborat deja propriile abordări cu privire la diferitele provocări și implicații ale conformității cu reglementările AI (e de menționat aici stupefiantul punct nr. 4 al Chinei, în care se stipulează fără emoții că se urmărește consolidarea integrării civil-militare în domeniul AI).

Tentativa reglementării AI din timp este binevenită, doar că e problematică. Vorba vine, „din timp”. În mod ipocrit, chiar Elon Musk – care explorează și el posibilitățile AI în afacerile sale, deși la început a fost categoric împotriva tehnologiei – a propus alături de alți antreprenori o pauză de 6 luni de la dezvoltarea tehnologiei, ca omenirea să aibă timp să gestioneze corect și în detaliu necesitatea reglementării AI („În urmă cu șase luni, Elon Musk a cerut o pauză pe AI. În schimb, dezvoltarea s-a accelerat”, a titrat Wired pe 28 septembrie 2023).

Marea problemă e că nici oamenii de știință nu înțeleg 100% cum funcționează AI.

Și nu e de mirare.

Nici neurologii nu cunosc în întregimea lui, nici în ziua de azi, mecanismul creierului uman. S-ar putea să fim, totuși, destul de aproape, să fim în faza în care „zgâriem suprafața”, cum s-ar spune, din moment ce inteligența artificială funcționează – cum spuneam mai sus – tocmai pe baza unei rețele neurale (artificial neural network). Și dincolo de latura fascinantă a acestei descoperiri, această nouă etapă a științei vine automat cu riscuri pentru întreaga omenire. De aceea, reglementarea este indispensabilă.

Având un potențial imens în atâtea domenii (atât avantaje, cât și dezavantaje), reglementarea AI are însă multe fațete.

Din câte am văzut, mulți pun accentul pe „gender bias”, adică discriminearea de gen (vezi aceste articole, pe Reuters și pe site-ul UNESCO). E și asta o problemă în lumea politically correct în care trăim, presupun, dar cu siguranță nu cea mai importantă dintre toate.

Problema copyright-ului este, de asemenea, intens dezbătută, deși rezolvarea ar fi simplă. O soluție ar fi ca chatboturile AI să specifice, obligatoriu, sursele. Ar fi chiar ceva extrem de simplu pentru un AI și ar fi chiar diferența notabilă față de om. În cazul meu, în momentul de față, este puțin diferit: deși sunt convins că tot ce scriu reprezintă ideile mele, trebuie să admit că este foarte posibil să fiu inspirat, de fapt, de alți oameni mai deștepti decât mine. Dacă-mi scormonesc mintea, pot să dau exemple de cărți: „Brief Answers to the Big Questions” de Stephen Hawking, „Sapiens” și „Homo Deus” de Yuval Noah Harari (deși pe cea din urmă nu am terminat-o), „Matrioșka Mincinoșilor” de Marian Voicu, probabil puțin și din „Gena egoistă” de Richard Dawkins… dar ar mai fi o sumedenie de articole de presă și de specialitate, surse de informație pe care, din memorie, fără să verific istoria browserului, nu le-aș mai putea identifica acum. Pentru un AI, însă, e floare la ureche.

Am văzut că s-a propus și implementarea licențierii de conținut (numit „Copyleft AI with Trusted Enforcement – CAITE”) – deși mi se pare doar o complicare birocratică și demagogică a problemei.

Se discută și de extinderea transparenței algoritmice, dar și aceasta pare mai degrabă o măsură de rezolvare și atenționare strict juridică abia după producerea unor pagube, nu are nimic de-a face cu prevenția.

Pe lângă afișarea surselor, ideal ar fi dacă AI ar urmări un program (stabilit de experți umani) care delimitează până la cel mai mic detaliu ce este și ce nu este autentic și credibil.

Dar asta deja se cam bate cap în cap cu libertatea de expresie și cu „dreptul” inteligenței artificiale de a se perfecționa folosind propriile „judecăți”, propriul program „machine learning” (învățare automată), fiind o formă de îngrădire a acestei libertăți, printr-un set întreg de reglementări, care – pe deasupra – mai și diferă în funcție de companie, țară sau continent.

Mă întreb: există un real interes pentru reglementarea preventivă a inteligenței artificiale?

Și care ar fi rezultatul unui ipotetic succes deplin în reglementarea AI?

Mă tem că va deveni o fațadă, o tehnologie controlată, de fapt, tot de oameni cu putere economică, politică, ori militară.

Asta ar fi cea mai extremă și macabră ipoteză: implementarea sau infiltrarea AI în strategii politico-militare.

Să nu uităm: „fundația” înțelegerii și învățării AI este omenirea, cu tot ce implică asta, inclusiv și în special părțile sale maligne. Și astfel ajungem la cea mai cruntă întrebare:

Va putea un AI să lanseze o rachetă nucleară, la un moment dat?

CONTROL vs. SCĂPAREA DE SUB CONTROL

În ciuda forțării notei, întrebarea (mai ales prin prisma crizelor politice din ultimul timp) nu este deloc neglijabilă.

Spuneam, în prima parte, că am să încerc să nu sun prăpăstios, că am considerat mereu că alarmiștii văd doar și doar partea negativă, că nu văd „the big picture”… dar în acest punct îmi e greu să nu trec în cealaltă tabără. „The Big Picture” e mult prea mare.

„Începuturile acestei noi ere a războiului vor fi dominate de inteligența artificială. Țara care reușește să integreze cel mai rapid și mai eficient noua tehnologie în lupte, câștigă” – a spus Alexandr Wang, fondatorul și CEO-ul Scale AI, la o conferință a Congresului american – subcomisia pentru serviciile armate, în vara anului trecut.

Omul de știință Stephen Hawking a avertizat lumea asupra acestui lucru, afirmând că succesul creării AI ar fi cel mai mare eveniment în istoria omenirii, dar din nefericire, ar putea fi chiar ultimul, dacă nu învățăm să evităm riscurile.

Citez din cartea „Brief Answers to the Big Questions” („Răspunsuri scurte la marile întrebări”), apărută în 2018: „De ce suntem atât de îngrijorați de inteligența artificială? Este sigur că oamenii sunt întotdeauna capabili să o scoată din priză? Oamenii au întrebat un computer: «Există un Dumnezeu?», iar computerul a spus: «Există acum» și a scurtcircuitat priza”.

De curând, în mai 2023, „nașul inteligenței artificiale”, Geoffrey Hinton, a demisionat de la Google și a tras semnalul de alarmă asupra pericolelor AI. „Cred că este absolut posibil ca umanitatea să fie doar o fază trecătoare în evoluția inteligenței”, a spus Hinton într-un podcast MIT Technology Review.

Unii spun că am ajuns la un punct de cotitură în evoluția omenirii, că suntem în pragul unui dezastru informațional. Un „dead end” în labirintul curiozității.

(Imagine din serialul „Westworld” / HBO)

Aș vrea să nu cred asta. Aici intervine optimismul meu, un sentiment ce se bazează doar pe încrederea – probabil, naivă – în umanitate. În cele din urmă, cred că sentimentul uman va învinge. Doar că… îmi dau seama, asta are două tăișuri.

Sentimentele pozitive sau cele negative vor „triumfa”, totuși? Nimic nou sub soare. E un joc de noroc al așa-zisei sorți.

Omenirea a trecut prin milenii de pericole și dezastre, răutăți, crime, minciuni, istorisiri devenite povești și mituri alterate, ficționalizate și mai mult pe parcurs (fake news, practic), ca să nu mai vorbim de războaie stupide. Și cu toate astea, am evoluat. Aș spune „cu siguranță”, dar în realitate sper că vom trece și peste acest impas numit „AI”, ori „revoluție informațională”.

În definitiv, de oameni va depinde totul, nu de AI.

Din păcate… pentru oameni, nimic nu este incoruptibil. Nici măcar un AI.

Reglementarea AI este pentru siguranța și binele omenirii, dar depinde cum, de către cine și cu ce scop se va face „reglementarea”.

Cine va avea controlul?

În marile crize ale omenirii, fie din motive naturale, fie artificiale, interesul celor puțini (al politicienilor, al conducătorilor lumii și al multimiliardarilor) a fost să prospere în haos. Pacea, înțelegerea, înțelepciunea și adevărul pot fi și ele profitabile în termeni de business și politică… dar cu limite. Iar oamenii au tendința să forțeze limitele. Deci cui va fi un real ajutor cel mai super-, supremul AI?

Ce comenzi va urmări acel AI? Propriile comenzi… ori comenzile controlate, induse de oameni? Dacă prima: vor fi comenzi bazate pe tot ceea ce a învățat de la noi, de la oameni?

Va rămâne – până și în forma sa superioară – ceea ce este acum: o inteligență plagiată?

Dar întrebarea esențială cred că e, în cele din urmă: vom învăța noi din greșelile noastre cu ajutorul AI, ori va învăța AI în locul nostru?

Ca să închei – vorba vine – cum se cuvine, l-am întrebat pe ChatGPT ce „părere” are: cum poate fi reglementată AI când, în mod fundamental, se bazează pe plagierea omenirii, cu toate defectele sale?

Răspunsul dat de ChatGPT:

„Reglementarea inteligenței artificiale poate implica stabilirea unor standarde etice și legale clare, monitorizarea dezvoltării tehnologiei AI, și implementarea unor mecanisme de control pentru prevenirea abuzurilor. Este important să se promoveze transparența, responsabilitatea și implicarea părților interesate în procesul de reglementare pentru a gestiona potențialele riscuri și impacturi negative”.

„Dezvoltă ideea” – i-am spus, dar era deja limpede că lecția esențială i-a fost „predată”.

Nicio vorbă despre plagierea omenirii, totuși.

Răspunsul final al ChatGPT:

„Reglementarea inteligenței artificiale ar trebui să cuprindă aspecte precum:

1. *Standarde Etice:*

– Stabilirea unor principii etice clare pentru dezvoltarea și utilizarea AI, astfel încât să fie aliniată cu valorile societății.

– Protejarea drepturilor fundamentale ale indivizilor și evitarea discriminării bazate pe rasă, gen sau alte caracteristici.

2. *Responsabilitate și Transparență:*

– Clarificarea responsabilităților dezvoltatorilor și utilizatorilor AI în ceea ce privește acuratețea, siguranța și consecințele utilizării tehnologiei.

– Impunerea unor cerințe de transparență în procesul de luare a deciziilor AI pentru a înțelege și explica modul în care sunt luate deciziile.

3. *Auditabilitate și Monitorizare:*

– Implementarea unor mecanisme de auditare care să permită revizuirea proceselor decizionale ale AI pentru a asigura conformitatea cu standardele etice și legale.

– Monitorizarea continuă a evoluției tehnologice și ajustarea reglementărilor în funcție de noile dezvoltări.

4. *Colaborare Internațională:*

– Stabilirea unor standarde globale pentru reglementarea AI, având în vedere caracterul transcendent al tehnologiei și evitarea unor discrepanțe semnificative între jurisprudențe.

5. *Instruire și Conștientizare:*

– Dezvoltarea unor programe de instruire și conștientizare pentru profesioniștii din domeniul AI și utilizatorii finali pentru a promova practici responsabile.

6. *Sancțiuni și Remedii:*

– Definirea clară a sancțiunilor pentru încălcările regulamentelor AI, împreună cu mecanisme de remediere pentru cei afectați.

În esență, reglementarea ar trebui să ghideze evoluția AI într-un mod care să aducă beneficii societății, minimizând riscurile și asigurând că tehnologia este utilizată în mod responsabil și etic”.

Citește și:

Enola Day – Cetățeni sau netățeni, natural sau artificial? (2)

Comentariile portalului

@jurjac te exprimi prin idei stereotipice și generalități lansate tocmai de extremiști deși e mult spus extremiști. Tratamentele aplicate în spitale au fost aceleași în (...)

noi votam Falca!!

@Vaccinatul Eu sunt de părere că Wiener a pus mâna la organizarea spitalului Covid și la impunerea unui tratament identic pentru toți pacienții, același tratament (...)