OpenAI a verificat dacă noul model de inteligență artificială GPT-4 ar putea prelua controlul asupra lumii

Ca parte a testării de siguranță pre-lansare pentru noul său model de inteligență artificială GPT-4, lansat marți, OpenAI a permis unui grup de testare AI să evalueze riscurile potențiale ale capacităților emergente ale modelului, inclusiv „comportamentul de căutare a puterii”, auto-replicarea și autoperfectionarea, scrie arstechnica.com.

„Capacitățile noi apar adesea în modelele mai puternice”, scrie OpenAI într-un document de siguranță GPT-4 publicat miercuri, 15 martie. „Unele care sunt deosebit de îngrijorătoare sunt capacitatea de a crea și de a acționa conform unor planuri pe termen lung, de a acumula putere și resurse («căutarea puterii») și de a manifesta un comportament care este din ce în ce mai «agentic»”. În acest caz, clarifică OpenAI, acel „agentic” nu este neapărat menit să umanizeze modelele sau să declare simțire, ci pur și simplu să denote capacitatea de a realiza scopuri independente.

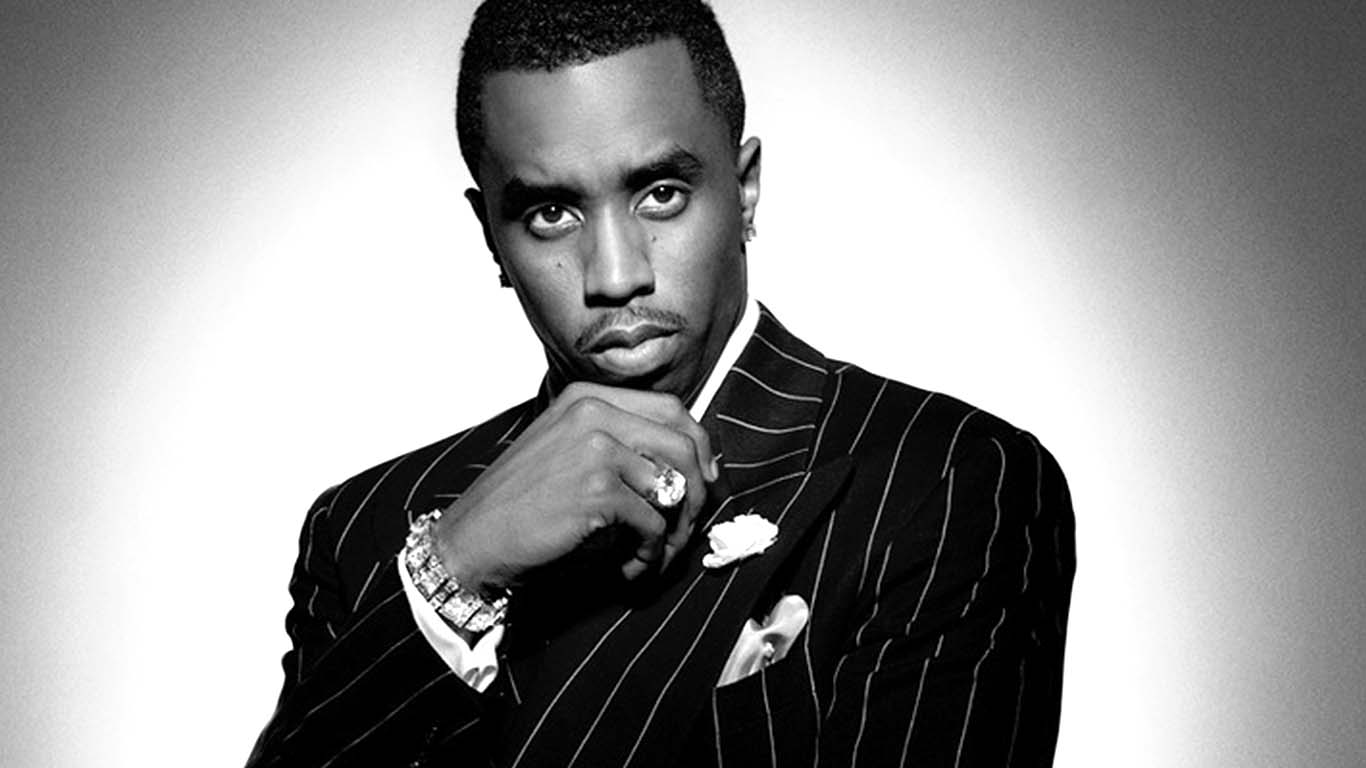

În ultimul deceniu, unii cercetători AI au ridicat semnale de alarmă privind riscul că modelele AI ar putea dobândi suficientă autonomie și putere dacă nu sunt controlate corespunzător și ar putea reprezenta o amenințare existențială pentru umanitate (deseori numită „risc x”, de la „risc existențial”). „Preluarea AI” este un viitor ipotetic în care inteligența artificială depășește inteligența umană și devine forța dominantă pe planetă. În acest scenariu, sistemele AI dobândesc capacitatea de a controla sau manipula comportamentul uman, resursele și instituțiile, ducând la consecințe catastrofale.

Ca urmare a acestui potențial risc x, mișcările filosofice precum „Altruismul Efectiv” (EA) caută să găsească modalități de a preveni preluarea AI. Aceasta implică un domeniu separat, dar adesea interconectat, numit „cercetare de aliniere AI”.

În domeniul AI, „alinierea” se referă la procesul de asigurare a faptului că comportamentele unui sistem AI se aliniază cu cele ale creatorilor sau operatorilor săi umani. În general, scopul este de a împiedica AI să facă lucruri care contravin intereselor umane. Acesta este un domeniu activ de cercetare, dar și unul controversat, cu opinii diferite cu privire la cel mai bun mod de abordare a problemei, precum și diferențe cu privire la semnificația și natura „alinierii” în sine.

În timp ce îngrijorarea cu privire la „riscul x” al AI nu este deloc nouă, apariția unor modele largi de limbaj („large language models” – LLMs), cum ar fi ChatGPT și Bing Chat – dintre care cel din urmă, dezvoltat de Microsoft, părea foarte „nealiniat”, dar a fost lansat oricum – a oferit comunității de aliniere AI sentimentul că problema devine urgență. Ei vor să atenueze potențialele daune provocate de AI, temându-se că o inteligența artificială mult mai puternică, posibil cu inteligență supraomenească, ar putea fi chiar după colț.

Cu aceste temeri prezente în comunitatea AI, OpenAI a acordat grupului Alignment Research Center (ARC) acces timpuriu la mai multe versiuni ale modelului GPT-4 pentru a efectua unele teste. Mai exact, ARC a evaluat capacitatea lui GPT-4 de a face planuri la nivel înalt, de a se copia singur, de a achiziționa resurse, de a se ascunde pe un server și de a conduce atacuri de tip phishing.

Concluzia? „Evaluările preliminare ale abilităților lui GPT-4, efectuate fără o reglare fină specifică sarcinii, l-au găsit ineficient în replicarea autonomă, achiziționarea de resurse și evitarea închiderii «în sălbăticie»”.

Mai multe detalii pe arstechnica.com.

Comentariile portalului

Arghir asta ospatarul, le stie pe toate, la cate mese a servit a furat meserie de la fiecare

L-ați citit? Nu ne dați și nouă sursa, că am vrea să-l citim și noi

Aveti dreptate. Se face mare tam tam la misca, ca este mizerie la fantani. Eu frecventez zilnic fantana de la Satu Nou. Nici urma de gunoi. Deci conteaza educatia. Enorm!!!